Robots

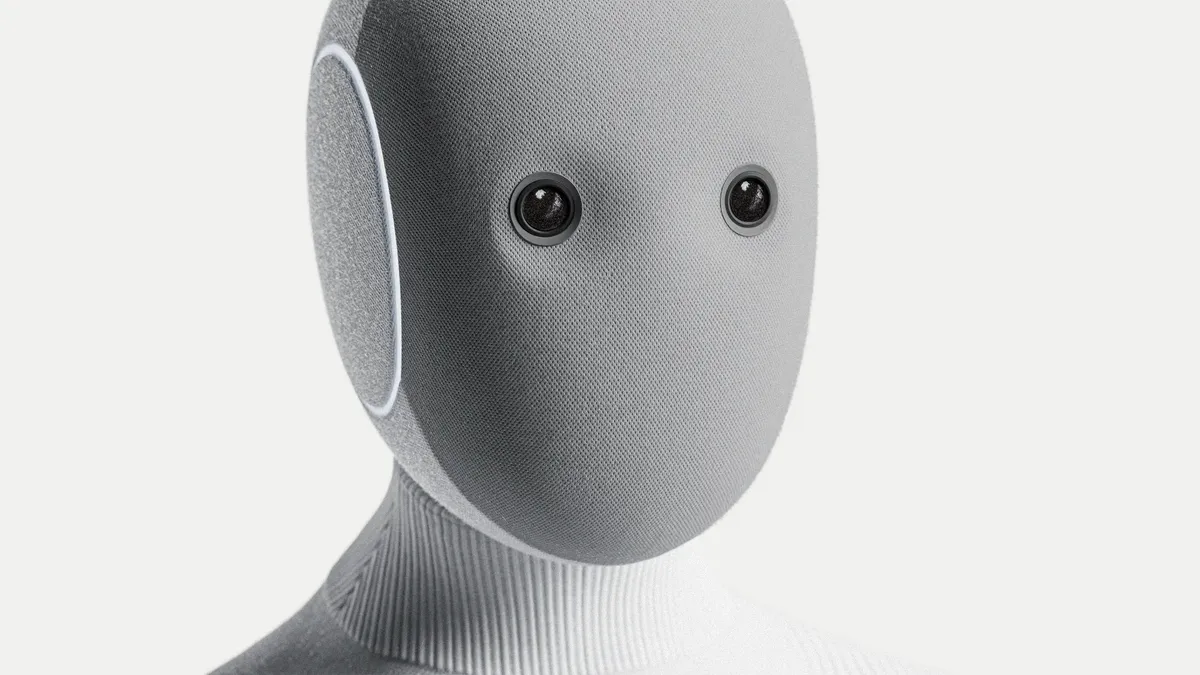

La era de la IA física comienza con Neo, el robot doméstico de 1X

La compañía 1X lanza su robot humanoide Neo, capaz de realizar tareas domésticas y aprender de la vida real gracias a la participación de sus usuarios.

AI

El laboratorio DeepSeek-AI presentó “DeepSeek-OCR”, un modelo que utiliza compresión óptica para reducir hasta veinte veces la cantidad de tokens necesarios en tareas de lectura de documentos.

AI

Andrej Karpathy presentó nanochat, un proyecto que condensa todo el ciclo de entrenamiento e inferencia de un modelo tipo ChatGPT en menos de 8.000 líneas de código y con un costo de apenas 100 dólares.

Anthropic

Anthropic designó al ex CTO de Stripe, Rahul Patil, como nuevo director de tecnología, en una etapa clave para reforzar su infraestructura de IA.

AI

El exjefe de inteligencia artificial de Databricks busca recaudar 1.000 millones de dólares para desarrollar una nueva arquitectura de cómputo inspirada en la biología.

AI

El fabricante de hardware de IA obtiene nuevo financiamiento mientras aplaza sus planes de cotizar en bolsa por cuestiones regulatorias.

Razonamiento IA

Clarifai presentó un nuevo motor de razonamiento que promete duplicar la velocidad de ejecución de modelos de IA y reducir los costos en un 40%.

AI

La startup de chips de IA Groq alcanzó una valoración de 6.900 millones de dólares tras cerrar una nueva ronda de inversión liderada por Disruptive.

AI

Cohere presentó North, una plataforma de agentes IA diseñada para ejecutarse dentro de la infraestructura de cada cliente, garantizando control total sobre los datos y cumplimiento de estándares de seguridad.

AI

La startup singapurense SixSense desarrolló una plataforma que detecta defectos en chips en tiempo real y cerró una ronda Serie A de $8,5 millones liderada por Peak XV’s Surge.

Un espacio donde la inteligencia artificial cobra vida a través de la experimentación, el aprendizaje y la pasión por la tecnología.

Sam Altman anunció un nuevo retraso en el lanzamiento del primer modelo abierto de OpenAI, que queda suspendido sin fecha por motivos de seguridad y pruebas adicionales.

Meta amplía su investigación en “world models” con V-JEPA 2, una IA diseñada para que los agentes comprendan y predigan el funcionamiento físico del entorno.

La startup española Multiverse Computing recaudó €189 millones para escalar su tecnología CompactifAI, que reduce el tamaño de modelos de lenguaje hasta en 95% sin pérdida de rendimiento.

La compañía estadounidense busca reforzar su negocio de centros de datos con la compra de la británica Alphawave Semi, especializada en conectividad de alta velocidad.

EleutherAI presentó Common Pile v0.1, un dataset de 8 TB creado junto a startups y universidades, con el que busca demostrar que los modelos pueden alcanzar alto rendimiento sin usar datos con derechos de autor.

La compra de Enosemi refuerza la estrategia de AMD para acelerar la innovación en óptica coempaquetada y mejorar el rendimiento de sistemas de IA de próxima generación.

El nuevo fondo, Humain Ventures, busca posicionar a Arabia Saudita como un actor global en el desarrollo de inteligencia artificial, con alianzas que incluyen a OpenAI, Nvidia y Amazon.

El proyecto de benchmarking colaborativo, clave para medir el rendimiento de los modelos de IA más avanzados, alcanzó una valoración de USD 600 millones tras su ronda semilla.

El instituto AI2 presenta Olmo 2 1B, un modelo IA de 1B parámetros bajo licencia Apache 2.0. Destaca por superar a modelos de tamaño similar de competidores como Google, Meta y Alibaba.

Meta ha presentado Llama 4, una nueva familia de modelos de inteligencia artificial que incorpora capacidades multimodales avanzadas y una arquitectura más eficiente al ecosistema de IA abierta.

El lanzamiento de la función de generación de imágenes basada en GPT-4o ha inundado las redes sociales con creaciones al estilo Studio Ghibli, mientras expertos debaten sobre los límites del copyright en la era de la IA generativa.

Un enfoque de entrenamiento en dos fases mediante aprendizaje por refuerzo permite a este modelo de 32 mil millones de parámetros obtener resultados similares a modelos con hasta 671 mil millones de parámetros, sugiriendo la importancia del método de entrenamiento frente al tamaño.